GCP Cloud Dataflow ?

Dataflow là một bộ SDK xác định mô hình lập trình mà bạn sử dụng để xây dựng xử lý pipeline streaming và batch. Google Cloud Dataflow là một dịch vụ được quản lý hoàn toàn để chuyển đổi và làm phong phú dự liệu trong chế độ Stream và Batch với độ tin cậy và expressiveness. Không cần giải pháp phức tạp. Với cách tiếp cận không cần máy chủ để cấp phép và quản lý tài nguyên, bạn có quyền truy cập vào khả năng vô hạn để giải quyết những vấn để xử lý dự liệu lớn của bạn và chị chi trả cho những gì bạn sử dụng.

Dataflow là một bộ SDK xác định mô hình lập trình mà bạn sử dụng để xây dựng xử lý pipeline streaming và batch. Google Cloud Dataflow là một dịch vụ được quản lý hoàn toàn để chuyển đổi và làm phong phú dự liệu trong chế độ Stream và Batch với độ tin cậy và expressiveness. Không cần giải pháp phức tạp. Với cách tiếp cận không cần máy chủ để cấp phép và quản lý tài nguyên, bạn có quyền truy cập vào khả năng vô hạn để giải quyết những vấn để xử lý dự liệu lớn của bạn và chị chi trả cho những gì bạn sử dụng.

Dataflow được sử dụng ở đâu?

- ETL: Movement, Filtering, Enrichment, Shaping

- Analysis: Reduction, Batch compulation, Continuous compulation

- Orchestraion: Composition, External orchestraion, Simulation

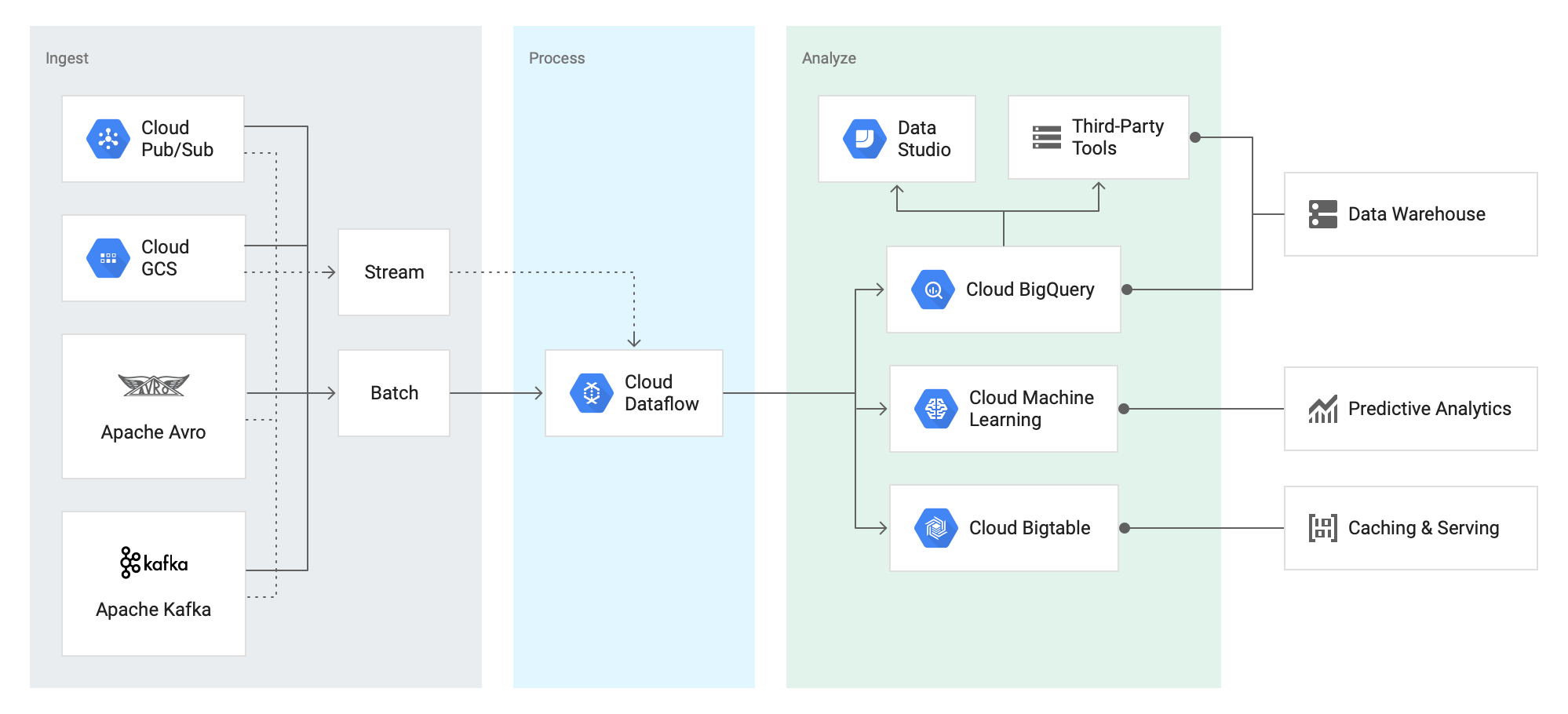

Chuyển đổi dữ liệu với Dataflow

Tính năng của Cloud Dataflow

- Quản lý tài nguyên tự động: Cloud Dataflow cung cấp và quản lý tài nguyên xử lý một cách tự động để giảm thiểu độ trễ và tối đa hóa việc sử dụng tài nguyên

- Tái cân bằng công việc: Tự động và tối ưu hóa phân vùng làm việc. Không cần phải …. Hoặc xử lý trước dự liệu đầu vào

- Xử lý chính xác và nhất quán: Cung cấp built-in supprt để thực thi khả năng chịu lỗi phù hợp và chính xác bất kể kích thước dữ liệu, kích thước cluster, pattern xử lý hay pipeline phức tạp

- Horizontal Auto-scaling: tự động mở rộng tài nguyên làm việc cho kết quả tối ưu dẫn đến hiệu suất tổng thể tốt hơn.

- Mô hình lập trình thống nhất: Apache Beam SDK cung cấp các hoạt động giống như MapReduce, cửa sổ dữ liệu mạnh mẽ và kiểm soát độ chính xác chi tiết cho dữ liệu streaming và batch giống nhau.

- Cải tiến theo hướng cộng đồng: Các nhà phát triển muốn mở rộng mô hình lập trình Cloud Dataflow có thể fork và / hoặc đóng góp cho Apache Beam.

Cloud Dataflow và Cloud Data proc. Nên sử dụng loại nào?

Cloud Dataproc và Cloud Dataflow đều có thể được sử dụng để xử lý dữ liệu và có sự chồng chéo trong khả năng batch và streaming. Vậy làm thế nào để bạn quyết định sản phẩm nào phù hợp hơn với môi trường của bạn?

Giá thành dịch vụ

- Server Taiwan

- Server Singapore